Los mejores agentes de usuario para web scraping y cómo usarlos

Aloísio Vítor

Image Processing Expert

07-Mar-2025

Al realizar web scraping, usar el agente de usuario incorrecto puede provocar bloqueos instantáneos. Los sitios web a menudo se basan en los agentes de usuario para diferenciar entre usuarios reales y bots. Para evitar la detección, es crucial usar agentes de usuario bien formados y frecuentemente actualizados en sus proyectos de web scraping.

En esta guía, descubrirás:

- Qué es un agente de usuario y por qué es importante para el web scraping

- Una lista de los mejores agentes de usuario para scraping

- Cómo establecer y rotar agentes de usuario en Python

- Mejores prácticas adicionales para evitar ser bloqueado

?Vamos a sumergirnos! ?

?Qué es un agente de usuario?

Un agente de usuario (UA) es una cadena enviada en los encabezados de la solicitud HTTP que identifica el navegador, el sistema operativo y otros detalles. Los servidores web utilizan esta información para representar el contenido apropiado para el dispositivo del usuario.

Ejemplo de una cadena de agente de usuario:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36Desglosándolo:

Mozilla/5.0– Familia del navegador(Windows NT 10.0; Win64; x64)– Detalles del sistema operativoAppleWebKit/537.36 (KHTML, like Gecko)– Motor de renderizadoChrome/123.0.0.0– Versión del navegadorSafari/537.36– Marco de compatibilidad

Al modificar el agente de usuario, puede hacer que su raspador web parezca un navegador real, reduciendo el riesgo de detección.

Por qué los agentes de usuario son importantes para el web scraping

La mayoría de los sitios web analizan los agentes de usuario para filtrar el tráfico de bots. Si su raspador envía un agente de usuario no válido o desactualizado, puede bloquearse instantáneamente.

Al usar un agente de usuario apropiado, puede:

- Imitar un navegador real y mezclarse con el tráfico normal.

- Omitir las protecciones anti-bot que verifican las bibliotecas de raspado predeterminadas.

- Mejorar las tasas de éxito de las solicitudes y evitar CAPTCHA o bloqueos de IP.

Sin embargo, usar solo un agente de usuario repetidamente aún puede activar los sistemas anti-bot. Es por eso que rotar los agentes de usuario es crucial.

Mejores agentes de usuario para web scraping (lista actualizada)

A continuación, se muestra una lista seleccionada de agentes de usuario efectivos para web scraping:

Agentes de usuario de Google Chrome:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36

Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36

Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36Agentes de usuario de Mozilla Firefox:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0

Mozilla/5.0 (Macintosh; Intel Mac OS X 14.4; rv:124.0) Gecko/20100101 Firefox/124.0

Mozilla/5.0 (X11; Linux i686; rv:124.0) Gecko/20100101 Firefox/124.0Otros navegadores:

plaintext

Mozilla/5.0 (Macintosh; Intel Mac OS X 14_4_1) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/17.4.1 Safari/605.1.15

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36 Edg/123.0.2420.81? Consejo: Puede comprobar su propio agente de usuario visitando WhatIsMyUserAgent.

Cómo establecer un agente de usuario personalizado en Python

Muchos sitios web implementan mecanismos de detección de bots que bloquean las solicitudes con encabezados de agente de usuario que faltan o son incorrectos. En esta sección, vamos con diferentes maneras de establecer y rotar agentes de usuario de manera eficiente.

1. Usando la biblioteca requests

La forma más sencilla de definir un agente de usuario es modificando los encabezados de una solicitud usando la popular biblioteca requests.

Ejemplo: Establecer un agente de usuario estático

python

import requests

# Definir encabezados con un agente de usuario personalizado

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

}

# Enviar una solicitud con el agente de usuario personalizado

response = requests.get("https://httpbin.org/headers", headers=headers)

# Imprimir los encabezados de la respuesta

print(response.text)Salida:

json

{

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

}

}Esto confirma que el servidor recibe y reconoce correctamente la cadena del agente de usuario.

2. Rotar agentes de usuario para una mejor anonimidad

Usar un solo agente de usuario repetidamente puede provocar bloqueos. Para evitar esto, rote los agentes de usuario usando una lista predefinida.

Ejemplo: Rotar agentes de usuario con random

python

import requests

import random

# Lista de diferentes agentes de usuario

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0"

]

# Seleccionar un agente de usuario aleatorio

headers = {"User-Agent": random.choice(user_agents)}

# Enviar una solicitud con el agente de usuario elegido aleatoriamente

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Al rotar los agentes de usuario, su raspador parece más humano y reduce las posibilidades de detección.

3. Usando fake_useragent para la generación dinámica de agentes de usuario

En lugar de mantener una lista estática, puede generar dinámicamente agentes de usuario usando la biblioteca fake_useragent.

Instalación:

sh

pip install fake-useragentEjemplo: Generar agentes de usuario aleatorios

python

from fake_useragent import UserAgent

import requests

# Crear un objeto UserAgent

ua = UserAgent()

# Generar un agente de usuario aleatorio

headers = {"User-Agent": ua.random}

# Enviar una solicitud con un agente de usuario generado dinámicamente

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Este método proporciona una variedad más amplia de agentes de usuario mientras los mantiene actualizados.

4. Establecer un agente de usuario personalizado en Selenium

Cuando se usa Selenium para web scraping, establecer un agente de usuario requiere modificar las opciones del navegador.

Ejemplo: Establecer un agente de usuario en Chrome

python

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

# Configurar las opciones de Chrome

chrome_options = Options()

chrome_options.add_argument("user-agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36")

# Iniciar el navegador con agente de usuario personalizado

driver = webdriver.Chrome(options=chrome_options)

# Abrir una página de prueba para verificar el agente de usuario

driver.get("https://httpbin.org/headers")

# Extraer e imprimir el contenido de la página

print(driver.page_source)

driver.quit()Al usar herramientas de automatización del navegador como Selenium, puede simular el comportamiento del usuario real y omitir las medidas avanzadas anti-bot.

5. Verificar su agente de usuario

Para asegurarse de que su agente de usuario esté configurado correctamente, use los siguientes métodos:

- Verifique los encabezados de respuesta de

https://httpbin.org/headers - Use las herramientas para desarrolladores del navegador (F12 > Red > Encabezados) para inspeccionar las solicitudes

- Use el registro para confirmar la rotación del agente de usuario en los raspadores

Ejemplo: Registrar agentes de usuario en un bucle

python

import requests

import random

import time

# Lista de agentes de usuario

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0"

]

# Bucle a través de las solicitudes

for i in range(5):

user_agent = random.choice(user_agents)

headers = {"User-Agent": user_agent}

response = requests.get("https://httpbin.org/headers", headers=headers)

print(f"Solicitud {i+1} - Agente de usuario: {user_agent}")

time.sleep(2) # Agregar retraso para evitar la limitación de velocidadEste script registra diferentes agentes de usuario en varias solicitudes, lo que le ayuda a depurar las estrategias de rotación.

Cómo rotar agentes de usuario a escala

En lugar de usar un solo agente de usuario estático, es mejor rotarlos dinámicamente para evitar la detección. Así es como puede rotar los agentes de usuario en Python:

python

import requests

import random

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

]

headers = {"User-Agent": random.choice(user_agents)}

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Este script selecciona aleatoriamente un agente de usuario de la lista, lo que hace que su raspador sea más difícil de detectar.

Mejores prácticas adicionales para evitar ser bloqueado

Incluso con los mejores agentes de usuario, el web scraping requiere técnicas adicionales para permanecer sin ser detectado:

- Use proxies para evitar bloqueos de IP.

- Implemente retrasos e intervalos aleatorios entre solicitudes.

- Rote los encabezados y los patrones de solicitud para imitar el comportamiento humano.

- Evite el raspado excesivo para evitar activar los límites de velocidad.

- Monitoree los códigos de respuesta para detectar bloqueos y adaptarse en consecuencia.

Incluso con la rotación de agentes de usuario y proxy y todos esos consejos, los sitios web aún pueden implementar técnicas de detección avanzadas, como huellas dactilares, desafíos de JavaScript y verificación de CAPTCHA. Aquí es donde entra en juego CapSolver.

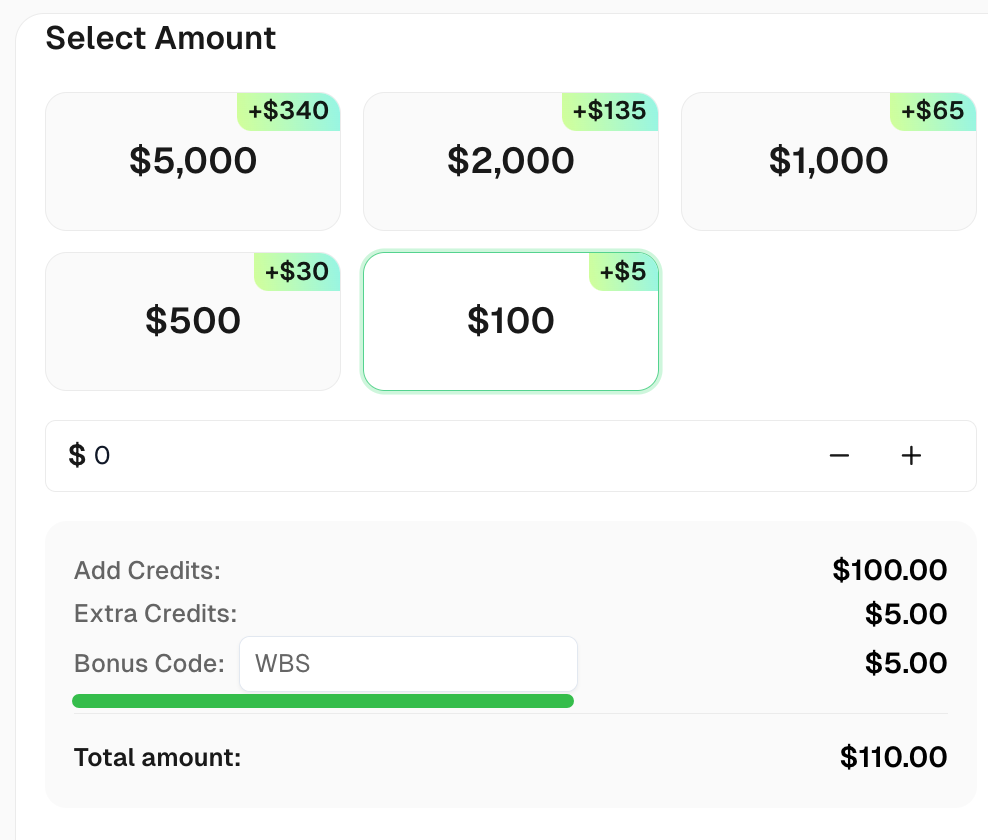

CapSolver se especializa en resolver desafíos de CAPTCHA, asegurando un web scraping ininterrumpido. Al integrar CapSolver, puede resolver automáticamente los CAPTCHA y mantener su raspador funcionando sin problemas

Reclama tu Código de bonificación para las mejores soluciones de captcha -CapSolver: CAPTCHA. Después de canjearlo, obtendrás un bono adicional del 5% después de cada recarga, Ilimitado

Conclusión

Usar los agentes de usuario correctos es un paso crítico en el web scraping. En esta guía, cubrimos:

? Qué es un agente de usuario y cómo funciona

? Una lista de agentes de usuario efectivos para scraping

? Cómo establecer y rotar agentes de usuario en Python

? Mejores prácticas adicionales para permanecer sin ser detectado

Al combinar la rotación del agente de usuario con otras técnicas anti-detección, puede raspar datos con éxito sin ser bloqueado.

Preguntas frecuentes

1. ?Qué es un agente de usuario en web scraping?

Un agente de usuario es una cadena que identifica el navegador o el software cliente a un servidor web. En web scraping, se utiliza para imitar la actividad del usuario real y evitar la detección.

2. ?Es ilegal el web scraping para uso personal?

El web scraping generalmente es legal para uso personal, pero debe respetar los términos de servicio de un sitio web y evitar raspar datos confidenciales o con derechos de autor.

3. ?Cuál es el propósito de la rotación del agente de usuario en web scraping?

La rotación del agente de usuario ayuda a evitar la detección y el bloqueo al hacer que las solicitudes parezcan provenir de diferentes navegadores o dispositivos.

4. ?Cómo puedo evitar ser bloqueado mientras hago web scraping?

Para evitar el bloqueo, use la rotación de IP, la resolución de CAPTCHA, los retrasos entre solicitudes y asegúrese de cumplir con el robots.txt del sitio.

5. ?Puede el web scraping afectar el rendimiento de un sitio web?

Sí, raspar con demasiada frecuencia puede sobrecargar el servidor de un sitio web. Es importante raspar de manera responsable con solicitudes limitadas.

Aviso de Cumplimiento: La información proporcionada en este blog es solo para fines informativos. CapSolver se compromete a cumplir con todas las leyes y regulaciones aplicables. El uso de la red de CapSolver para actividades ilegales, fraudulentas o abusivas está estrictamente prohibido y será investigado. Nuestras soluciones para la resolución de captcha mejoran la experiencia del usuario mientras garantizan un 100% de cumplimiento al ayudar a resolver las dificultades de captcha durante el rastreo de datos públicos. Fomentamos el uso responsable de nuestros servicios. Para obtener más información, visite nuestros Términos de Servicio y Política de Privacidad.

Máse

Cómo resolver cualquier versión de reCAPTCHA Enterprise v2, v2 invisible, v3, v3 Enterprise puntuación 0.9

Domina la resolución de cualquier versión de reCaptcha con CapSolver: Este guía proporciona un tutorial paso a paso para resolver reCaptcha de manera efectiva, garantizando resultados precisos cada vez.

Aloísio Vítor

11-Oct-2025

Cómo resolver captchas de imagen

Esta entrada de blog proporciona una guía completa sobre cómo resolver captchas de imagen utilizando CapSolver, una herramienta dise?ada para automatizar el proceso. Comienza explicando qué es un captcha de imagen, seguido de una guía paso a paso detallada sobre cómo usar la API de CapSolver para resolver estos captchas. La guía incluye ejemplos de las solicitudes y respuestas involucradas en el proceso. La entrada concluye con una nota sobre la eficiencia y la conveniencia de usar CapSolver para resolver captchas de imagen, convirtiéndola en una fuente invaluable para quienes buscan automatizar tareas que involucran la resolución de captchas.

Emma Foster

11-Oct-2025

Cómo resolver reCaptcha versión 2 Invisible

Este blog sirve como una guía completa sobre cómo resolver reCaptcha v2 invisible utilizando Capsolver. Proporciona una guía paso a paso, desde enviar la información necesaria a Capsolver hasta verificar los resultados. El blog está dise?ado para ser fácil de entender y seguir, haciendo que el proceso de implementar y resolver reCaptcha v2 invisible en tu sitio web sea rápido y eficiente. Es una guía única y extensa, asegurando que los lectores adquieran una comprensión completa del proceso sin ningún plagio.

Adélia Cruz

11-Oct-2025

Resolver reCaptcha v2 Enterprise

En el mundo digital, la seguridad y la comodidad del usuario a menudo se encuentran en extremos opuestos del espectro. Los CAPTCHAs, específicamente reCaptcha, han sido fundamentales para equilibrar los dos aspectos. Sin embargo, ?qué pasa si necesitas resolver las pruebas de reCaptcha a menudo complejas y que consumen mucho tiempo, especialmente la versión Enterprise de reCaptcha V2, para un propósito legítimo como pruebas automatizadas? En este blog, te guiaremos a través del proceso de resolver reCaptcha V2 Enterprise utilizando la API de CapSolver.

Adélia Cruz

11-Oct-2025

Resolver reCaptcha v3

Aprende a resolver reCaptcha V3 usando CapSolver: diversos tipos de tareas, integración de API simple y soluciones efectivas para automatización y pruebas

Aloísio Vítor

10-Oct-2025

Cómo resolver Captcha en Crawl4AI con CapSolver integración

Extracción de datos web fluida con Crawl4AI & CapSolver: solución automática de CAPTCHA, mayor eficiencia y extracción de datos robusta para la IA.

Adélia Cruz

26-Sep-2025