Melhores agentes de usuário para web scraping e como usá-los

Adélia Cruz

Neural Network Developer

07-Mar-2025

Ao realizar web scraping, usar o agente de usuário errado pode levar a bloqueios instant?neos. Os sites geralmente contam com agentes de usuário para diferenciar usuários reais de bots. Para evitar a detec??o, é crucial usar agentes de usuário bem formados e frequentemente atualizados em seus projetos de web scraping.

Neste guia, você descobrirá:

- O que é um agente de usuário e por que ele importa para web scraping

- Uma lista dos melhores agentes de usuário para scraping

- Como configurar e rotacionar agentes de usuário em Python

- Boas práticas adicionais para evitar ser bloqueado

Vamos mergulhar! ?

O que é um agente de usuário?

Um Agente de Usuário (UA) é uma string enviada nos cabe?alhos de solicita??o HTTP que identifica o navegador, o sistema operacional e outros detalhes. Os servidores web usam essas informa??es para renderizar o conteúdo apropriado para o dispositivo do usuário.

Exemplo de uma string de agente de usuário:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36Desmembrando:

Mozilla/5.0– Família do navegador(Windows NT 10.0; Win64; x64)– Detalhes do sistema operacionalAppleWebKit/537.36 (KHTML, like Gecko)– Mecanismo de renderiza??oChrome/123.0.0.0– Vers?o do navegadorSafari/537.36– Estrutura de compatibilidade

Ao modificar o agente de usuário, você pode fazer com que seu web scraper pare?a um navegador real, reduzindo o risco de detec??o.

Por que os agentes de usuário s?o importantes para web scraping

A maioria dos sites analisa os agentes de usuário para filtrar o tráfego de bots. Se seu scraper enviar um agente de usuário inválido ou desatualizado, ele pode ser bloqueado instantaneamente.

Usando um agente de usuário apropriado, você pode:

- Imitar um navegador real e se misturar ao tráfego normal.

- Contornar as prote??es anti-bot que verificam as bibliotecas de scraping padr?o.

- Melhorar as taxas de sucesso das solicita??es e evitar CAPTCHAs ou bloqueios de IP.

No entanto, usar apenas um agente de usuário repetidamente ainda pode disparar sistemas anti-bot. ? por isso que rotacionar os agentes de usuário é crucial.

Melhores agentes de usuário para web scraping (lista atualizada)

Abaixo está uma lista selecionada de agentes de usuário eficazes para web scraping:

Agentes de usuário do Google Chrome:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36

Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36

Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36Agentes de usuário do Mozilla Firefox:

plaintext

Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0

Mozilla/5.0 (Macintosh; Intel Mac OS X 14.4; rv:124.0) Gecko/20100101 Firefox/124.0

Mozilla/5.0 (X11; Linux i686; rv:124.0) Gecko/20100101 Firefox/124.0Outros navegadores:

plaintext

Mozilla/5.0 (Macintosh; Intel Mac OS X 14_4_1) AppleWebKit/605.1.15 (KHTML, like Gecko) Version/17.4.1 Safari/605.1.15

Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36 Edg/123.0.2420.81? Dica: Você pode verificar seu próprio agente de usuário visitando WhatIsMyUserAgent.

Como definir um agente de usuário personalizado em Python

Muitos sites implementam mecanismos de detec??o de bots que bloqueiam solicita??es com cabe?alhos de agente de usuário ausentes ou incorretos. Nesta se??o, vamos usar diferentes maneiras de definir e rotacionar agentes de usuário de forma eficiente.

1. Usando a biblioteca requests

A maneira mais simples de definir um agente de usuário é modificando os cabe?alhos de uma solicita??o usando a popular biblioteca requests.

Exemplo: Definindo um agente de usuário estático

python

import requests

# Define headers with a custom User-Agent

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

}

# Send a request with the custom User-Agent

response = requests.get("https://httpbin.org/headers", headers=headers)

# Print the response headers

print(response.text)Saída:

json

{

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Host": "httpbin.org",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

}

}Isso confirma que o servidor recebe e reconhece corretamente a string do agente de usuário.

2. Rotacionando agentes de usuário para melhor anonimato

Usar um único agente de usuário repetidamente pode levar a bloqueios. Para evitar isso, rotacionar os agentes de usuário usando uma lista predefinida.

Exemplo: Rotacionando agentes de usuário com random

python

import requests

import random

# List of different user agents

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0"

]

# Select a random user agent

headers = {"User-Agent": random.choice(user_agents)}

# Send a request with the randomly chosen user agent

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Ao rotacionar os agentes de usuário, seu scraper parece mais humano e reduz as chances de detec??o.

3. Usando fake_useragent para gera??o din?mica de agente de usuário

Em vez de manter uma lista estática, você pode gerar dinamicamente agentes de usuário usando a biblioteca fake_useragent.

Instala??o:

sh

pip install fake-useragentExemplo: Gerando agentes de usuário aleatórios

python

from fake_useragent import UserAgent

import requests

# Create a UserAgent object

ua = UserAgent()

# Generate a random user agent

headers = {"User-Agent": ua.random}

# Send a request with a dynamically generated user agent

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Este método fornece uma variedade maior de agentes de usuário, mantendo-os atualizados.

4. Definindo um agente de usuário personalizado em Selenium

Ao usar Selenium para web scraping, definir um agente de usuário requer a modifica??o das op??es do navegador.

Exemplo: Definindo um agente de usuário no Chrome

python

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

# Configure Chrome options

chrome_options = Options()

chrome_options.add_argument("user-agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36")

# Start browser with custom user agent

driver = webdriver.Chrome(options=chrome_options)

# Open a test page to verify user agent

driver.get("https://httpbin.org/headers")

# Extract and print page content

print(driver.page_source)

driver.quit()Usando ferramentas de automa??o de navegador como o Selenium, você pode simular o comportamento do usuário real e contornar medidas anti-bot avan?adas.

5. Verificando seu agente de usuário

Para garantir que seu agente de usuário esteja configurado corretamente, use os seguintes métodos:

- Verifique os cabe?alhos de resposta de

https://httpbin.org/headers - Use as ferramentas de desenvolvedor do navegador (F12 > Rede > Cabe?alhos) para inspecionar solicita??es

- Use log para confirmar a rota??o do agente de usuário em scrapers

Exemplo: Registrando agentes de usuário em um loop

python

import requests

import random

import time

# User agent list

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:124.0) Gecko/20100101 Firefox/124.0"

]

# Loop through requests

for i in range(5):

user_agent = random.choice(user_agents)

headers = {"User-Agent": user_agent}

response = requests.get("https://httpbin.org/headers", headers=headers)

print(f"Request {i+1} - User-Agent: {user_agent}")

time.sleep(2) # Add delay to avoid rate limitingEste script registra diferentes agentes de usuário em várias solicita??es, ajudando você a depurar estratégias de rota??o.

Como rotacionar agentes de usuário em escala

Em vez de usar um único agente de usuário estático, é melhor rotacioná-los dinamicamente para evitar a detec??o. Aqui está como você pode rotacionar agentes de usuário em Python:

python

import requests

import random

user_agents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36"

]

headers = {"User-Agent": random.choice(user_agents)}

response = requests.get("https://httpbin.org/headers", headers=headers)

print(response.text)Este script seleciona aleatoriamente um agente de usuário da lista, tornando seu scraper mais difícil de detectar.

Boas práticas adicionais para evitar ser bloqueado

Mesmo com os melhores agentes de usuário, o web scraping requer técnicas adicionais para permanecer indetectável:

- Use proxies para evitar bloqueios de IP.

- Implemente atrasos e intervalos aleatórios entre as solicita??es.

- Rotacionar cabe?alhos e padr?es de solicita??o para imitar o comportamento humano.

- Evite scraping excessivo para evitar disparar limites de taxa.

- Monitore os códigos de resposta para detectar bloqueios e adaptar-se de acordo.

Mesmo com rota??o de agente de usuário e proxy e todas essas dicas, os sites ainda podem implementar técnicas de detec??o avan?adas, como impress?o digital, desafios de JavaScript e verifica??o de CAPTCHA. ? aí que entra o CapSolver.

CapSolver é especializado em resolver desafios de Capttcha, garantindo web scraping ininterrupto. Ao integrar o CapSolver, você pode resolver CAPTCHAs automaticamente e manter seu scraper funcionando sem problemas

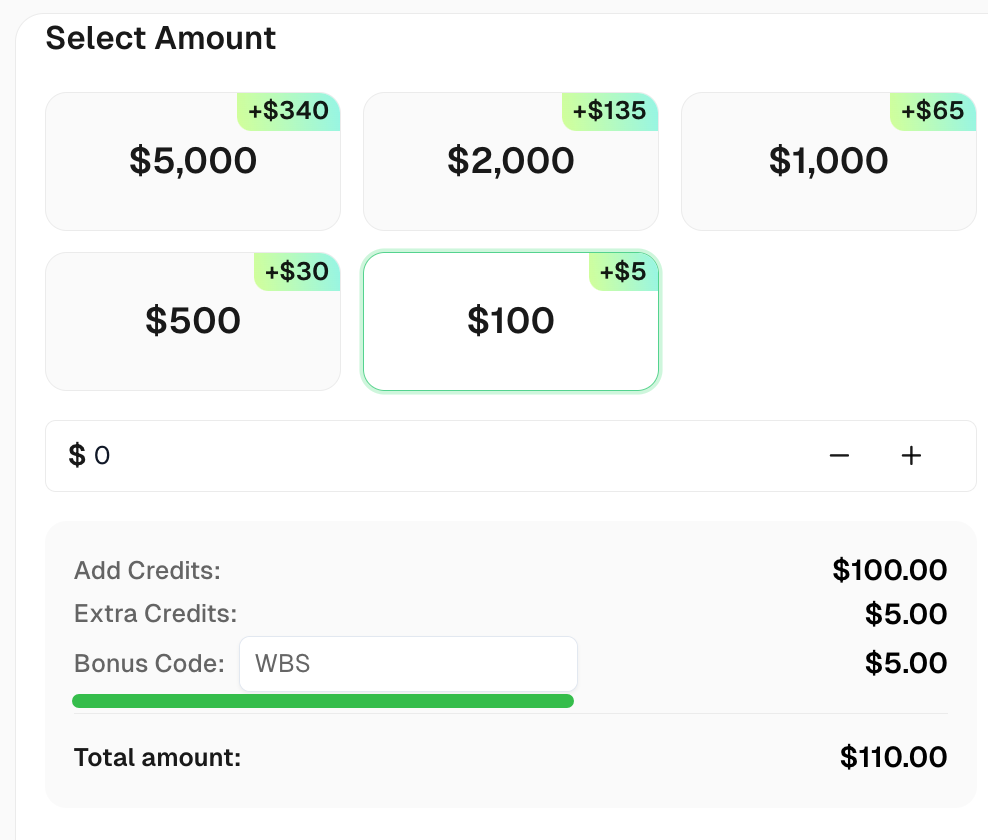

Solicite seu Código B?nus para as melhores solu??es de captcha -CapSolver: CAPTCHA. Após resgatá-lo, você receberá um b?nus extra de 5% após cada recarga, ilimitado

Conclus?o

Usar os agentes de usuário corretos é uma etapa crítica no web scraping. Neste guia, abordamos:

? O que é um agente de usuário e como ele funciona

? Uma lista de agentes de usuário eficazes para scraping

? Como configurar e rotacionar agentes de usuário em Python

? Boas práticas adicionais para permanecer indetectável

Ao combinar rota??o de agente de usuário com outras técnicas anti-detec??o, você pode raspar dados com sucesso sem ser bloqueado.

FAQ

1. O que é um agente de usuário em web scraping?

Um agente de usuário é uma string que identifica o navegador ou o software cliente para um servidor web. No web scraping, ele é usado para imitar a atividade de um usuário real e evitar a detec??o.

2. Web scraping para uso pessoal é ilegal?

Web scraping geralmente é legal para uso pessoal, mas você deve respeitar os termos de servi?o de um site e evitar raspar dados confidenciais ou protegidos por direitos autorais.

3. Qual é o objetivo da rota??o do agente de usuário em web scraping?

A rota??o do agente de usuário ajuda a evitar a detec??o e o bloqueio, fazendo com que as solicita??es pare?am vir de diferentes navegadores ou dispositivos.

4. Como posso evitar ser bloqueado durante o web scraping?

Para evitar bloqueios, use rota??o de IP, solu??o de CAPTCHA, atrasos entre as solicita??es e garanta a conformidade com o robots.txt do site.

5. Web scraping pode afetar o desempenho de um site?

Sim, raspar com muita frequência pode sobrecarregar o servidor de um site. ? importante raspar de forma responsável, com solicita??es limitadas.

Declara??o de Conformidade: As informa??es fornecidas neste blog s?o apenas para fins informativos. A CapSolver está comprometida em cumprir todas as leis e regulamentos aplicáveis. O uso da rede CapSolver para atividades ilegais, fraudulentas ou abusivas é estritamente proibido e será investigado. Nossas solu??es de resolu??o de captcha melhoram a experiência do usuário enquanto garantem 100% de conformidade ao ajudar a resolver dificuldades de captcha durante a coleta de dados públicos. Incentivamos o uso responsável de nossos servi?os. Para mais informa??es, visite nossos Termos de Servi?o e Política de Privacidade.

Mais

Como resolver qualquer vers?o do reCAPTCHA Enterprise v2, v2 invisível, v3, v3 empresa 0,9 ponto

Domine a resolu??o de qualquer vers?o do reCaptcha com o CapSolver: Este guia oferece um tutorial passo a passo para resolver o reCaptcha de forma eficaz, garantindo resultados precisos a cada vez.

Adélia Cruz

11-Oct-2025

Como resolver captchas de imagem

Este artigo de blog fornece um guia completo sobre como resolver captchas de imagem usando o CapSolver, uma ferramenta projetada para automatizar o processo. Ele come?a com uma explica??o do que é um captcha de imagem, seguido por um passo a passo detalhado sobre como usar a API do CapSolver para resolver esses captchas. O guia inclui exemplos das solicita??es e respostas envolvidas no processo. O artigo conclui com uma observa??o sobre a eficiência e a conveniência de usar o CapSolver para resolver captchas de imagem, tornando-o um recurso inestimável para aqueles que desejam automatizar tarefas que envolvem resolu??o de captchas.

Adélia Cruz

11-Oct-2025

Como resolver reCaptcha vers?o 2 Invisível

Este blog serve como um guia abrangente sobre como resolver reCaptcha v2 invisível usando Capsolver. Ele fornece um guia passo a passo, desde o envio das informa??es necessárias ao Capsolver até a verifica??o dos resultados. O blog foi projetado para ser fácil de entender e seguir, tornando o processo de implementar e resolver reCaptcha v2 invisível no seu site rápido e eficiente. ? um guia único e abrangente, garantindo que os leitores adquiram uma compreens?o completa do processo sem plágio.

Adélia Cruz

11-Oct-2025

Resolver reCaptcha v2 Empresarial

No mundo digital, seguran?a e conveniência do usuário frequentemente se encontram nos extremos opostos do espectro. CAPTCHAs, especificamente o reCaptcha, têm sido fundamentais para encontrar um equilíbrio entre os dois. No entanto, e se você precisar resolver os testes de reCaptcha frequentemente complexos e demorados, especialmente o reCaptcha V2 Enterprise, por um propósito legítimo como testes automatizados? Neste blog, vamos te mostrar o processo de resolver o reCaptcha V2 Enterprise usando a API do CapSolver.

Aloísio Vítor

11-Oct-2025

Resolver reCAPTCHA v3

Aprenda a resolver o reCaptcha V3 usando o CapSolver: diversos tipos de tarefas, integra??o simples da API e solu??es eficazes para automa??o e testes

Aloísio Vítor

10-Oct-2025

Como encontrar a fun??o de callback do reCaptcha

Encontrar o callback de um reCAPTCHA envolve identificar a fun??o JavaScript que é executada depois que o reCAPTCHA é resolvido com sucesso. Segue uma breve vis?o geral das etapas que você pode seguir.

Adélia Cruz

23-Sep-2025